Искусственный интеллект – это уже не только хайп. ИИ часто становится новым двигателем бизнеса. Компании вкладывают миллионы в AI-кластеры с тысячами мощных графических процессоров (GPU), чтобы обучать большие языковые модели (LLM). Но что, если эти дорогостоящие «мозги» большую часть времени простаивают, а проект затягивается на недели и месяцы? Причина часто кроется там, где ее не ищут – в сети.

Сеть для искусственного интеллекта не то же самое, что для обычного дата-центра. И эта разница в подходах напрямую влияет на скорость и стоимость ваших AI-проектов.

Хаос против синхронного марша: в чем ключевое отличие трафика

Чтобы понять проблему, давайте представим два типа объектов:

- Традиционный дата-центр – это как большой логистический хаб. Множество разных клиентов отправляют и получают свои «посылки» (данные): кто-то запрашивает баланс счета в банке, кто-то запускает ночной расчет отчетов. Задачи асинхронны, потоки данных разные по размеру, и если одна «посылка» немного задержится, ничего страшного не случится – протокол TCP все исправит.

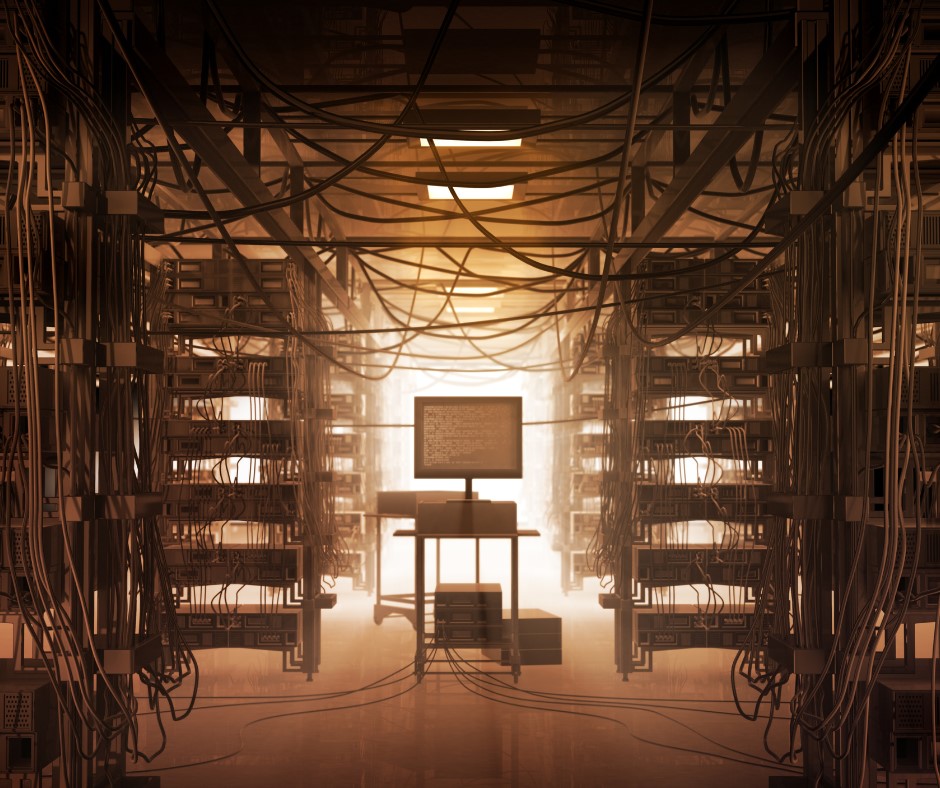

- AI-кластер – это, скорее, высокоточный сборочный конвейер. Тысячи GPU, как рабочие на линии, трудятся над одной общей задачей. Они работают синхронно: выполнив этап вычислений, все разом отправляют друг другу огромные массивы данных и ждут, пока дойдет информация от самого медленного участника.

Именно здесь кроется главная проблема. Если хоть один пакет данных задержится, весь «конвейер» из тысяч дорогих GPU будет простаивать. Это явление известно как «длинный хвост»: общая скорость работы определяется не средним, а самым медленным потоком данных.

Экономика «длинного хвоста»: почему просто добавить скорости – не выход

В традиционных дата-центрах, когда сеть начинает «тормозить», администраторы просто добавляют каналы связи. В AI-сетях этот подход не работает. Каналы здесь и так могут быть загружены на 90%, и простое удвоение их числа не решит проблему «пробок», возникающих из-за специфического трафика «все ко всем».

Главная цель оптимизации AI-сети не просто ускорить передачу данных, а сократить время простоя GPU. Ускорение процесса обучения даже на пару дней может сэкономить компании миллионы рублей, просто позволив быстрее запустить следующую задачу.

Ключ к успеху лежит в идеальной балансировке, чтобы все GPU получали данные практически одновременно.

Технологии для «сети без потерь»: как это работает

К счастью, сегодня не нужно изобретать велосипед. Современные сети на базе Ethernet уже имеют инструменты для оптимизации под AI-нагрузки. Вот основные из них:

- Прямая связь между GPU (RDMA / RoCE). Эта технология позволяет графическим процессорам обмениваться данными напрямую, минуя центральный процессор и операционную систему. Это как если бы рабочие на конвейере передавали детали из рук в руки, а не через склад. Значительно снижает задержки.

- Умное управление «пробками» (PFC, ECN, DCQCN). Это комплекс мер, который предотвращает потерю пакетов. ECN заранее предупреждает о возможной перегрузке, позволяя отправителю плавно снизить скорость. PFC работает как стоп-кран: он может на мгновение остановить передачу, если «пробка» все-таки возникла. DCQCN координирует их совместную работу.

- Идеальная балансировка (Packet Spraying). Вместо того чтобы отправлять весь большой поток данных по одному маршруту, сеть «разбивает» его на мелкие пакеты и рассылает по всем доступным путям. Это обеспечивает равномерную загрузку и предотвращает тот самый «длинный хвост».

Совместное использование этих технологий позволяет построить так называемую Lossless Ethernet, сеть «без потерь», которая критически важна для эффективной работы AI-кластера.

Не стройте вслепую! Почему тестирование – это необходимость?

Настройка всех этих технологий сложная задача. Неправильная конфигурация может не улучшить, а наоборот, замедлить работу сети. Как убедиться, что дизайн вашей сети оптимален, еще до закупки дорогостоящего оборудования?

Только с помощью специализированного тестирования. Для этого используются генераторы трафика (https://rutest.zone/ve), которые могут эмулировать поведение тысяч GPU и их специфический трафик. Такие инструменты позволяют в лабораторных условиях:

- Воспроизвести сценарии с различными моделями и размерами данных

- Измерить ключевые показатели производительности

- Найти «узкие места» в архитектуре и подобрать оптимальные настройки сети

Это не просто проверка, а шаг, который позволяет избежать дорогостоящих ошибок, минимизировать потери ресурсов и сократить затраты на создание и эксплуатацию всей AI-инфраструктуры. Требования к сетям для AI/ML радикально отличаются от традиционных. Оптимизация этой невидимой, но критически важной части инфраструктуры – сложная и необходимая задача. Понимание таких нюансов и использование профессиональных инструментов для проектирования и тестирования – это не технические мелочи, а прямое вложение в скорость и окупаемость AI-проектов.