По мере того, как приложения генеративного искусственного интеллекта (gen AI), такие как ChatGPT, стремительно захватывают мир, спрос на вычислительные мощности в дата-центрах стремительно растет.

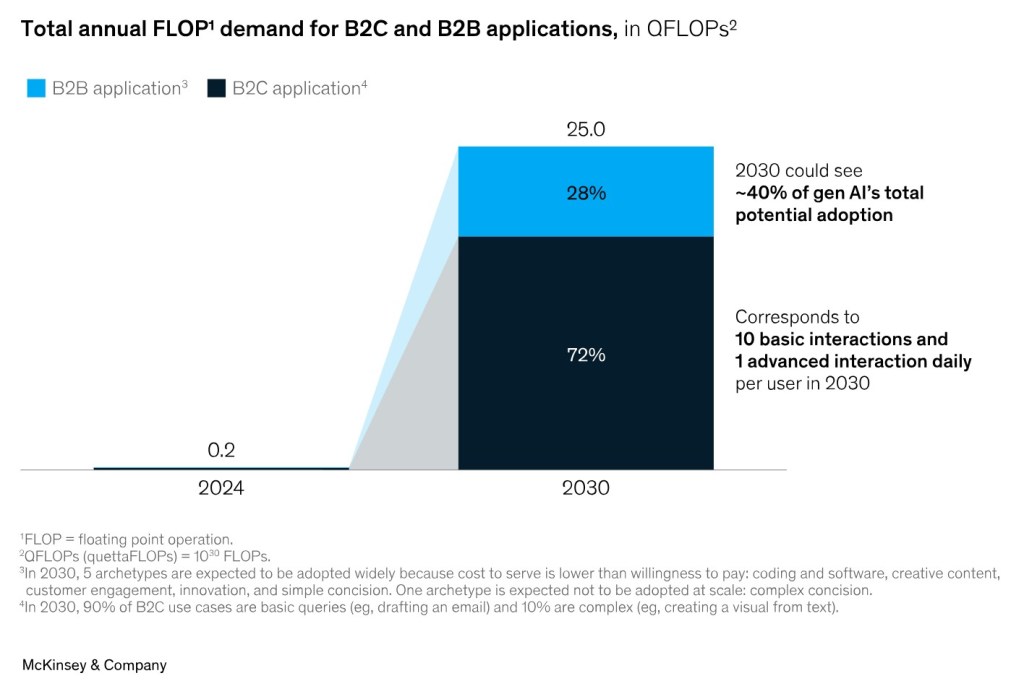

По оценкам McKinsey, к 2030 году в базовом сценарии общая потребность в вычислениях поколения ИИ может достичь 25×1030 FLOP (операций с плавающей запятой), при этом примерно 70 процентов придется на приложения B2C и 30 процентов на приложения B2B (Рисунок 1).

Рисунок 1. Рост спроса на вычислительную мощность в дата-центрах (источник:McKinsey)

Приложения Gen AI обычно работают на выделенных серверах в дата-центрах. На первый взгляд дата-центры для Gen AI могут выглядеть похожими на традиционные центры обработки данных, но между ними есть существенные различия.

Компоненты ИИ-сервера

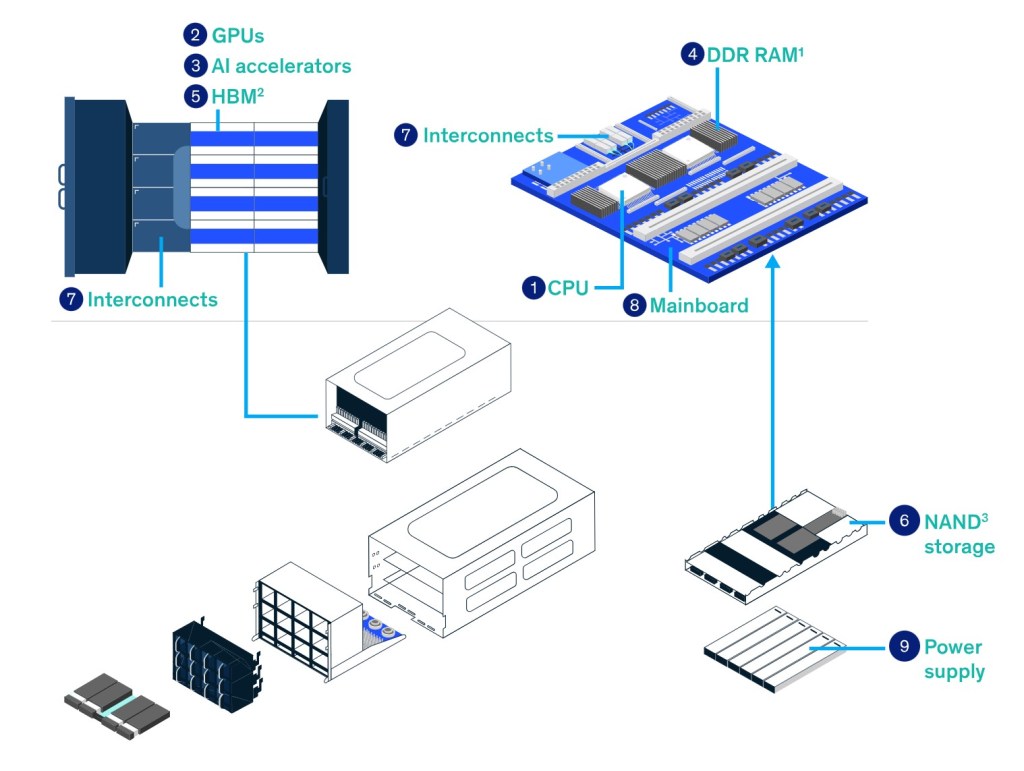

Дата-центры и серверы для ИИ отличаются от традиционных моделей. Существует девять компонентов серверов ИИ, которые наиболее важны для лидеров полупроводниковой отрасли.

Рисунок 2. Компоненты сервера для ИИ.

• CPU (central processing unit, центральный процессор). CPU управляет функциями системного уровня, координирует поток данных и выполняет задачи, требующие более обобщенного вычислительного подхода. Сотрудничество между центральными и специализированными процессорами обеспечивает сбалансированную и эффективную работу, оптимизируя использование сильных сторон каждого компонента на сервере искусственного интеллекта.

• GPU (graphics processing unit, графический процессор). Графический процессор — это специализированный процессор, предназначенный для параллельной обработки сложных математических вычислений, что делает его важным компонентом в центрах обработки данных искусственного интеллекта для ускорения обучения и вычислений.

• Ускоритель искусственного интеллекта (AI accelerator). Это специализированный полупроводниковый компонент, предназначенный для ускорения рабочих нагрузок ИИ за счет выполнения высокоскоростных вычислений и оптимизации стоимости и производительности алгоритмов ИИ в центрах обработки данных.

• Память DDR (double data rate memory, память с двойной скоростью передачи данных). Память DDR, вариант динамической оперативной памяти (DRAM), обеспечивает высокоскоростную энергозависимую память, обеспечивая быстрый доступ к данным и повышая общую производительность системы.

• HBM (high-bandwidth memory, память с высокой пропускной способностью). Вариант DRAM, HBM специально создан для случаев использования с очень высокой пропускной способностью, таких как обучение искусственного интеллекта и логический вывод, обеспечивая скорость, более чем в десять раз превышающую стандартную DRAM.

• Память NAND. Она используется для хранения операционной системы, моделей ИИ, данных пользователя и других компонентов.

• Межсоединения (Interconnects). Межсоединения, оснащенные оптическими приемопередатчиками, обеспечивают бесперебойную связь между вычислительными компонентами, обеспечивая эффективный обмен данными.

• Материнская плата (Mainboard). Материнская плата служит центральным узлом, координирующим взаимодействие различных компонентов, все они питаются от надежного блока питания и поддерживаются в оптимальных условиях с помощью охлаждающих вентиляторов. Заключенные в хорошо структурированное шасси, эти компоненты в совокупности образуют сложную архитектуру, необходимую для удовлетворения вычислительных потребностей генеративного искусственного интеллекта в выделенной среде центра обработки данных.

• Блок питания (Power supply unit). Сервер AI оснащен несколькими блоками питания с резервированием для снижения риска сбоя.

Плотность стоек (Rack densities), то есть мощность, потребляемая серверным шкафом, для дата-центров с ИИ наиболее сильно отличается от традиционных центров обработки данных. В центрах обработки данных общего назначения плотность мощности стоек составляет от 5 до 15 кВт, тогда как рабочие нагрузки для обучения ИИ могут потреблять 100 кВт, а в некоторых случаях — до 150 кВт. Эксперты оценивают плотность мощности до 250 кВт – 300 кВт в ближайшие несколько лет.

Кроме того, по мере увеличения удельной мощности стоек системы воздушного охлаждения будет заменяться жидкостными. Для жидкостного охлаждения непосредственно на кристалле и охлаждения с полным погружением также потребуются новые конструкции серверов и стоек, позволяющие выдерживать дополнительный вес.

Серверы

В ответ на растущий спрос на вычислительную мощность серверы будут использовать высокопроизводительные графические процессоры (GPU) или специализированные микросхемы искусственного интеллекта, такие как специализированные интегральные схемы (ASIC), для эффективной обработки рабочих нагрузок поколения AI при помощи параллельной обработки процессов. Сегодня ожидается, что инфраструктуры для обучения и вывода результатов обработки в ИИ будут разделяться одна от другой, поскольку потребность в вычислениях для вывода становится более специфичной для каждого сценария использования ИИ.

Обучение. Ожидается, что архитектура серверов для процесса обучения ИИ будет аналогична сегодняшним высокопроизводительным кластерным архитектурам, в которых все серверы в центре обработки данных подключены к высокоскоростному соединению с малой задержкой. В основном в архитектуре высокопроизводительных серверов ИИ используются два CPU и восемь GPU. Ожидается, что в 2030 году большинство обучающих нагрузок будет выполняться с использованием этого типа комбинации CPU+GPU. Также ожидается переход к дизайну «система в корпусе» (system-in-a-package) для графических процессоров и ускорителей искусственного интеллекта, при этом ожидается, что обе архитектуры будут сосуществовать.

Устройства вывода результатов обработки ИИ. Текущие рабочие нагрузки вывода выполняются в инфраструктуре, аналогичной рабочей нагрузке обучения. По мере того, как ИИ будет использоваться индивидуальными и бизнес-пользователями, ожидается, что рабочая нагрузка сместится, в основном, в сторону логики вывода, что отдает предпочтение специализированному оборудованию из-за более низкой стоимости, более высокой энергоэффективности и более быстрой или лучшей производительности для узкоспециализированных задач.

К 2030 году ожидается, что всё больше серверов ИИ, ориентированных на логические выводы, будут использовать комбинацию процессоров со специально созданными ускорителями ИИ на базе специализированных микросхем ASIC.

DDR и HBM

Серверы ИИ используют два типа оперативной памяти DRAM: HBM, подключенную к GPU или ускорителям, и оперативную память DDR, подключенную к CPU. HBM имеет более высокую пропускную способность, но требует больше микросхем для того же объема данных.

По мере того, как т.н. моделей ИИ становятся больше, в серверах для ИИ увеличивается объем оперативной памяти, при этом ёмкость и пропускная способность памяти являются узким местом для производительности вычислений на уровне системы.

Статическая память с произвольным доступом (SRAM) тестируется в различных микросхемах для увеличения объема оперативной памяти, но ее высокая стоимость ограничивает широкое распространение. Например, будущие алгоритмы ИИ могут требовать меньше памяти для каждого прогона вывода, замедляя общий рост потребности в памяти. Во-вторых, ускорители ИИ занимают меньше памяти по сравнению с архитектурой CPU+GPU и могут стать более популярными к 2030 году, когда рабочие нагрузки вывода будут расти. Это может означать потенциально более медленный рост спроса на память.

Ожидается, что, в консервативном сценарии, к 2030 году спрос на DRAM со стороны разработки приложений поколения BB составит от 5 до 13 миллионов чипов. В базовом сценарии DRAM потребность в DRAM составит от 7 до 21 миллиона чипов.

NAND-память

Память NAND используется для хранения данных, например, операционной системы, пользовательских данных, а также ввода и вывода. В 2030 году спрос на NAND, вероятно, будет обусловлен появлением выделенных серверов данных для видео и многомодельных данных. Эти данные потребуют значительного объема памяти (например, для обучения на видеопоследовательностях высокого разрешения и извлечения данных во время вывода). Ожидается, что общий спрос на NAND составит от 2 до 8 миллионов чипов. Учитывая, что требования к производительности NAND для ИИ будут такими же, как и для современных серверов, выполнение этого требования будет менее сложным по сравнению с логикой и DRAM.

Другие компоненты

Растущий спрос на вычислительные ресурсы создаст дополнительный спрос на многие другие типы чипов. Особого внимания заслуживают два типа:

Высокоскоростная сеть и межсоединение компонентов дата-центра. Для дата-центров с ИИ требуется высокая пропускная способность соединений низкая задержка между серверами и между различными компонентами серверов. Для создания всех соединений требуется большее количество сетевых интерфейсов и коммутаторов. Сегодня эти межсоединения в основном, выполняются на медных кабелях, но ожидается, что оптическая связь будет расширяться по мере роста требований к пропускной способности и задержке.

Силовые полупроводники для блоков питания. Серверам ИИ требуется большое количество электроэнергии, и в 2030 году они могут потреблять более 10 процентов мирового производства электроэнергии. Для этого потребуется множество силовых полупроводников внутри сервера и на реальных устройствах.

В заключение, можно сказать, что резкий рост спроса на приложения ИИ вызывает соответствующую потребность в вычислительных мощностях, стимулируя как инновации в программном обеспечении, так и значительные инвестиции в инфраструктуру центров обработки данных и полупроводниковой промышленности. Однако критический вопрос заключается в том, сможет ли полупроводниковая промышленность удовлетворить этот спрос. Для революции ИИ требуются высокие инвестиции в производственные мощности полупроводников, поэтому тщательная оценка ситуации имеет важное значение и разработки взгляда на его влияние на полупроводниковую промышленность.